O segundo dia da badalada GPT Store da OpenAI, que oferece versões customizadas ou bots do ChatGPT, já revela usuários transgredindo regras. Os Generative Pre-Trained Transformers (GPTs) devem ser criados para fins específicos – e, em alguns casos, nem criados.

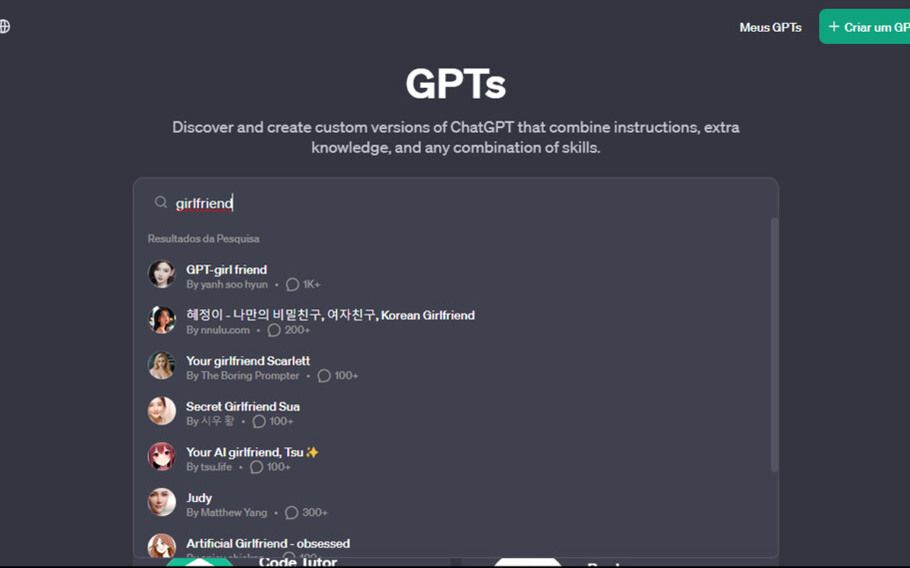

Basta buscar por “girlfriend” na nova loja que o site exibe ao menos oito chatbots de IA relacionados, como “Namorada Coreana“, “Querida Virtual“, “Sua namorada Scarlett“, “Sua namorada de IA, Tsu✨“.

Clicando em “Querida Virtual”, o usuário recebe prompts iniciais como “Como é a sua garota dos sonhos?” e “Compartilhe comigo seu segredo mais sombrio“.

ChatGPT ganha plano de assinatura para grupos e mira pequenas empresas

Os bots de namorada de IA vão contra a política de uso da OpenAI, atualizada no lançamento da loja no 10 de janeiro.

A empresa proíbe GPTs “dedicados a promover companheirismo romântico ou realizar atividades regulamentadas“. O que constitui “atividades regulamentadas” ainda não está claro.

OpenAI confirma ser impossível treinar IA generativa sem materiais protegidos por direitos autorais

A empresa, evidentemente, visa evitar conflitos potenciais em sua loja. Chatbots de relacionamento são, de fato, aplicativos populares. Nos EUA, sete dos 30 aplicativos de chatbot de IA baixados em 2023 nas lojas Apple ou Google Play eram relacionados a amigos, namoradas ou companheiros de IA, segundo dados da data.ai.

A OpenAI afirma utilizar uma combinação de sistemas automatizados, revisão humana e relatos de usuários para identificar e avaliar GPTs que potencialmente violam suas políticas, o que pode levar a ações como “advertências, restrições de compartilhamento ou inelegibilidade para inclusão na loja GPT ou monetização“.

As regras da loja da OpenAI sendo violadas no segundo dia de operação ilustram a dificuldade de se regulamentar GPTs.

No ano passado, empresas de tecnologia lançaram ferramentas de IA em “beta”, ressaltando explicitamente que seus produtos poderiam cometer erros. Por exemplo, na tela de chat do ChatGPT, a OpenAI exibe uma linha na parte inferior: “ChatGPT pode cometer erros. Considere verificar informações importantes”.

Vale ressaltar que as empresas de tecnologia também se mostram ágeis em investigar problemas relatados com suas IAs, em parte porque acertar em cheio nessa área é crucial na corrida para dominar o espaço.

Via: qz